Docker 和 Kubernetes(k8s)

Docker 和 Kubernetes(k8s)都是容器化技术的关键组件,但它们在容器生态系统中起到不同的作用。

Docker

- Docker 是一种容器技术,它允许开发者将应用程序及其依赖项打包到一个容器中。这有助于实现应用程序的隔离和一致性。

- Docker 提供了一个轻量级的虚拟化方式,让应用程序在不同环境中以相同的方式运行,从而简化了开发、测试和部署过程。

- Docker 主要关注单个容器的创建、管理和运行。

Kubernetes(k8s):

- Kubernetes 是一个容器编排平台,用于自动化容器部署、扩展和管理。它的主要目标是简化大规模容器应用程序的管理。

- Kubernetes 能够在多个节点上调度、管理和扩展容器,实现容器的负载均衡和自动恢复。

- Kubernetes 提供了一整套功能,如服务发现、存储管理、自动扩容、滚动更新等,以支持容器应用程序的生命周期管理。

总结起来,Docker 是一种容器技术,用于将应用程序及其依赖项封装到单独的容器中。而 Kubernetes 是一个容器编排和管理平台,用于部署和管理大规模的容器化应用程序。这两个技术互补,通常一起使用以实现现代、可扩展的应用程序部署。

一、初识Docker

1.1.什么是Docker

微服务虽然具备各种各样的优势,但服务的拆分通用给部署带来了很大的麻烦。

- 分布式系统中,依赖的组件非常多,不同组件之间部署时往往会产生一些冲突。

- 在数百上千台服务中重复部署,环境不一定一致,会遇到各种问题

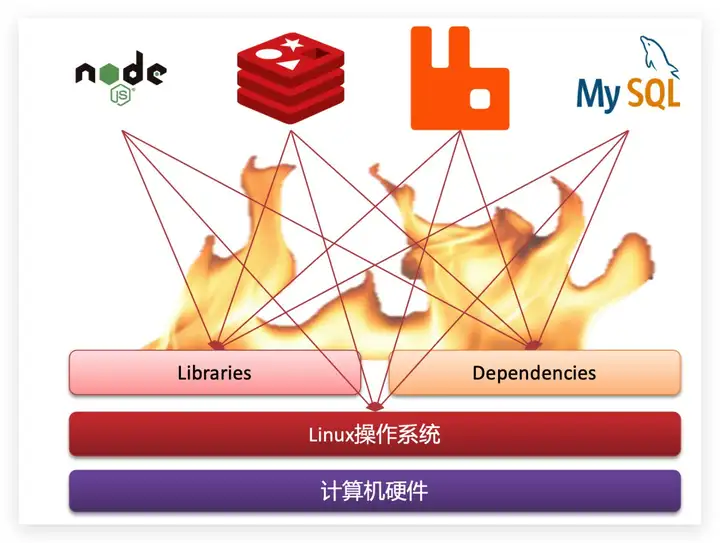

1.1.1.应用部署的环境问题

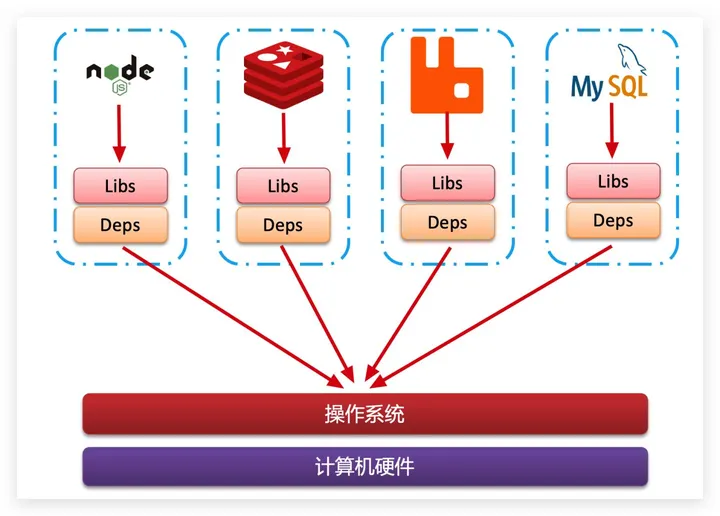

大型项目组件较多,运行环境也较为复杂,部署时会碰到一些问题:

- 依赖关系复杂,容易出现兼容性问题

- 开发、测试、生产环境有差异

例如一个项目中,部署时需要依赖于node.js、Redis、RabbitMQ、MySQL等,这些服务部署时所需要的函数库、依赖项各不相同,甚至会有冲突。给部署带来了极大的困难。

1.1.2.Docker解决依赖兼容问题

而Docker确巧妙的解决了这些问题,Docker是如何实现的呢?

Docker为了解决依赖的兼容问题的,采用了两个手段:

- 将应用的Libs(函数库)、Deps(依赖)、配置与应用一起打包

- 将每个应用放到一个隔离容器去运行,避免互相干扰

这样打包好的应用包中,既包含应用本身,也保护应用所需要的Libs、Deps,无需再操作系统上安装这些,自然就不存在不同应用之间的兼容问题了。

虽然解决了不同应用的兼容问题,但是开发、测试等环境会存在差异,操作系统版本也会有差异,怎么解决这些问题呢?

1.1.3.Docker解决操作系统环境差异

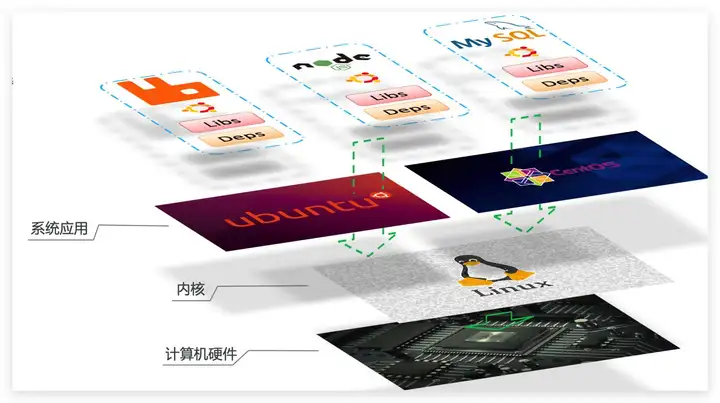

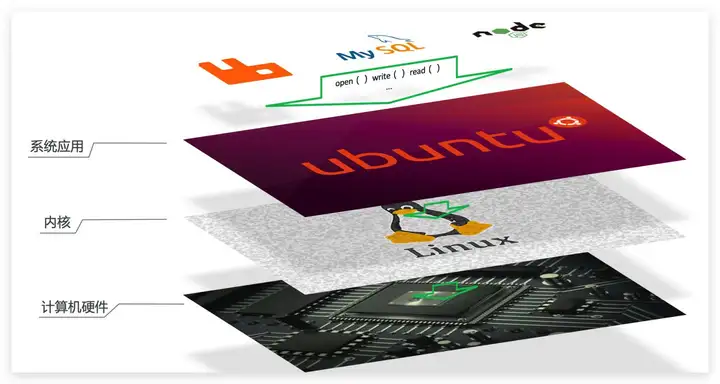

要解决不同操作系统环境差异问题,必须先了解操作系统结构。以一个Ubuntu操作系统为例,结构如下:

结构包括:

- 计算机硬件:例如CPU、内存、磁盘等

- 系统内核:所有Linux发行版的内核都是Linux,例如CentOS、Ubuntu、Fedora等。内核可以与计算机硬件交互,对外提供内核指令,用于操作计算机硬件。

- 系统应用:操作系统本身提供的应用、函数库。这些函数库是对内核指令的封装,使用更加方便。

应用于计算机交互的流程如下:

1)应用调用操作系统应用(函数库),实现各种功能

2)系统函数库是对内核指令集的封装,会调用内核指令

3)内核指令操作计算机硬件

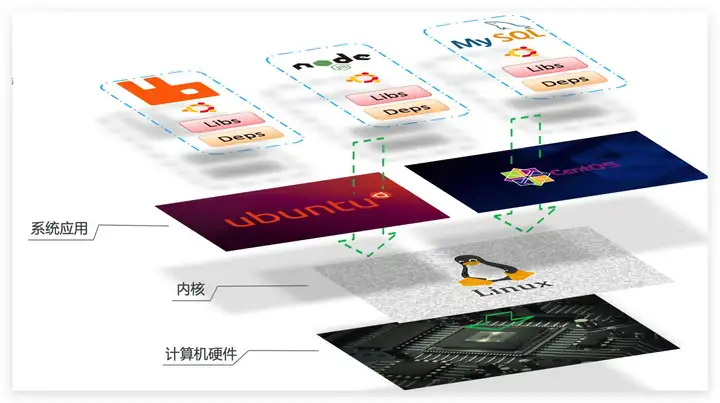

Ubuntu和CentOSpringBoot都是基于Linux内核,无非是系统应用不同,提供的函数库有差异:

此时,如果将一个Ubuntu版本的MySQL应用安装到CentOS系统,MySQL在调用Ubuntu函数库时,会发现找不到或者不匹配,就会报错了:

Docker如何解决不同系统环境的问题?

- Docker将用户程序与所需要调用的系统(比如Ubuntu)函数库一起打包

- Docker运行到不同操作系统时,直接基于打包的函数库,借助于操作系统的Linux内核来运行

如图:

1.1.4.小结

Docker如何解决大型项目依赖关系复杂,不同组件依赖的兼容性问题?

- Docker允许开发中将应用、依赖、函数库、配置一起打包,形成可移植镜像

- Docker应用运行在容器中,使用沙箱机制,相互隔离

Docker如何解决开发、测试、生产环境有差异的问题?

- Docker镜像中包含完整运行环境,包括系统函数库,仅依赖系统的Linux内核,因此可以在任意Linux操作系统上运行

Docker是一个快速交付应用、运行应用的技术,具备下列优势:

- 可以将程序及其依赖、运行环境一起打包为一个镜像,可以迁移到任意Linux操作系统

- 运行时利用沙箱机制形成隔离容器,各个应用互不干扰

- 启动、移除都可以通过一行命令完成,方便快捷

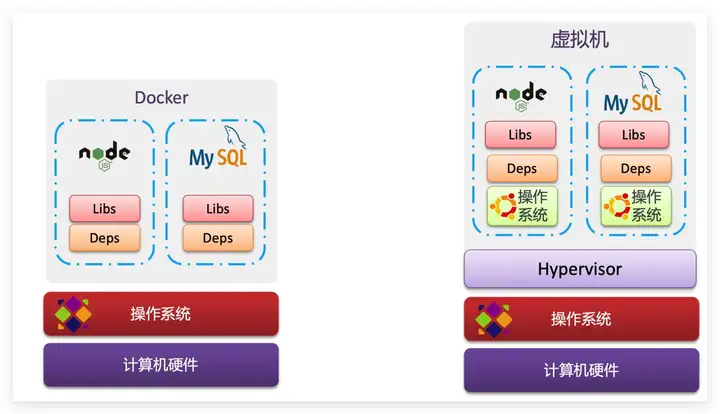

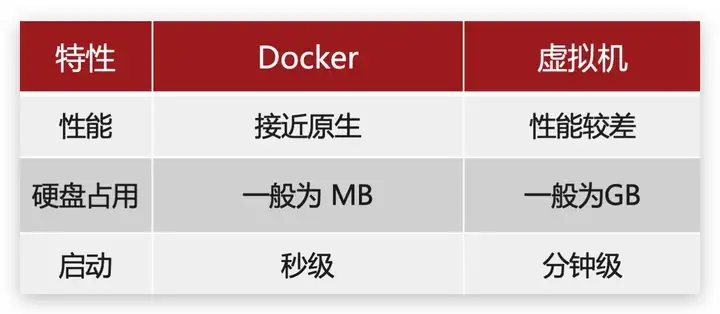

1.2.Docker和虚拟机的区别

Docker可以让一个应用在任何操作系统中非常方便的运行。而以前我们接触的虚拟机,也能在一个操作系统中,运行另外一个操作系统,保护系统中的任何应用。

两者有什么差异呢?

虚拟机(virtual machine)是在操作系统中模拟硬件设备,然后运行另一个操作系统,比如在 Windows 系统里面运行 Ubuntu 系统,这样就可以运行任意的Ubuntu应用了。

Docker仅仅是封装函数库,并没有模拟完整的操作系统,如图:

对比来看:

小结:

Docker和虚拟机的差异:

- docker是一个系统进程;虚拟机是在操作系统中的操作系统

- docker体积小、启动速度快、性能好;虚拟机体积大、启动速度慢、性能一般

1.3.Docker架构

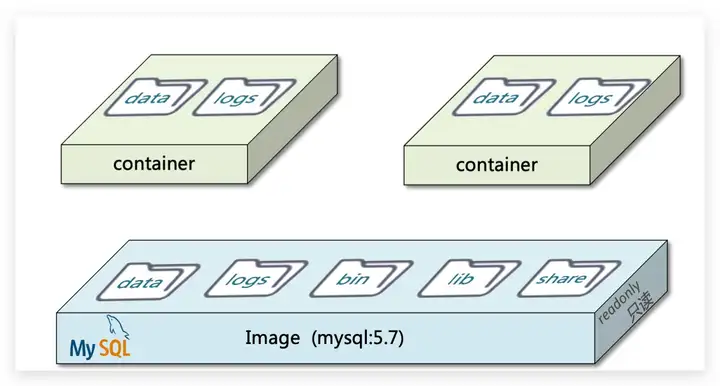

1.3.1.镜像和容器

Docker中有几个重要的概念:

镜像(Image):Docker将应用程序及其所需的依赖、函数库、环境、配置等文件打包在一起,称为镜像。

容器(Container):镜像中的应用程序运行后形成的进程就是容器,只是Docker会给容器进程做隔离,对外不可见。

一切应用最终都是代码组成,都是硬盘中的一个个的字节形成的文件。只有运行时,才会加载到内存,形成进程。

而镜像,就是把一个应用在硬盘上的文件、及其运行环境、部分系统函数库文件一起打包形成的文件包。这个文件包是只读的。

容器呢,就是将这些文件中编写的程序、函数加载到内存中允许,形成进程,只不过要隔离起来。因此一个镜像可以启动多次,形成多个容器进程。

例如你下载了一个QQ,如果我们将QQ在磁盘上的运行文件及其运行的操作系统依赖打包,形成QQ镜像。然后你可以启动多次,双开、甚至三开QQ,跟多个妹子聊天。

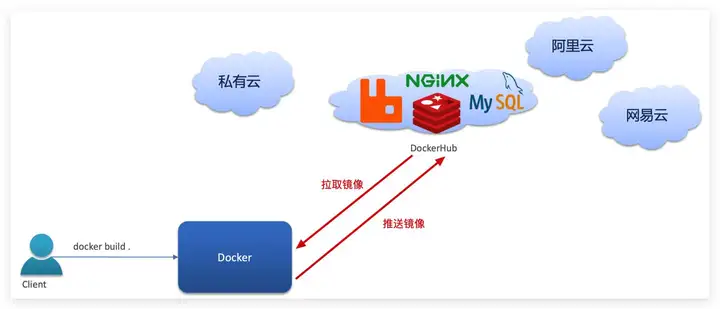

1.3.2.DockerHub

开源应用程序非常多,打包这些应用往往是重复的劳动。为了避免这些重复劳动,人们就会将自己打包的应用镜像,例如Redis、MySQL镜像放到网络上,共享使用,就像GitHub的代码共享一样。

- DockerHub:DockerHub是一个官方的Docker镜像的托管平台。这样的平台称为Docker Registry。

- 国内也有类似于DockerHub 的公开服务,比如 网易云镜像服务、阿里云镜像库等。

我们一方面可以将自己的镜像共享到DockerHub,另一方面也可以从DockerHub拉取镜像:

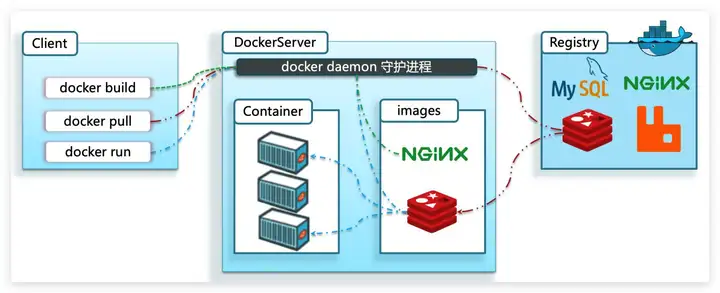

1.3.3.Docker架构

我们要使用Docker来操作镜像、容器,就必须要安装Docker。

Docker是一个CS架构的程序,由两部分组成:

- 服务端(server):Docker守护进程,负责处理Docker指令,管理镜像、容器等

- 客户端(client):通过命令或RestAPI向Docker服务端发送指令。可以在本地或远程向服务端发送指令。

如图:

1.3.4.小结

镜像:

- 将应用程序及其依赖、环境、配置打包在一起

容器:

- 镜像运行起来就是容器,一个镜像可以运行多个容器

Docker结构:

- 服务端:接收命令或远程请求,操作镜像或容器

- 客户端:发送命令或者请求到Docker服务端

DockerHub:

- 一个镜像托管的服务器,类似的还有阿里云镜像服务,统称为DockerRegistry1.4.安装Docker

二、 Kubernetes的概念

Kubernetes(k8s)是一个基于容器技术的的分布式架构解决方案,是Google开源的容器集群管理系统,Google内部称为Borg,主要用于自动部署、扩展和管理容器化的应用程序,是以Docer为基础的分布式系统架构。 Kubernetes可以对分布式系统进行完美的支撑,它具备完善的集群控制能力,内建有智能的负载均衡器,拥有强大的故障发现和自我修复能力。同时还针对开发、部署测试、运维监控等提供了完善的管理工具。

Kubernetes的核心思想是:一切以服务为中心,根据这一核心思想,Kubernetes可以让在其上构建的系统独立运行在物理机、虚拟机群或者云上,所以,Service(服务)是Kubernetes进行分布式集群构建的核心,必须拥有如下关键特征:

- 拥有一个唯一指定的名称。

- 拥有一个虚拟IP和端口。

- 能够提供某种远程服务能力。

- 可以被映射到提供这种远程服务能力的一组容器应用上。

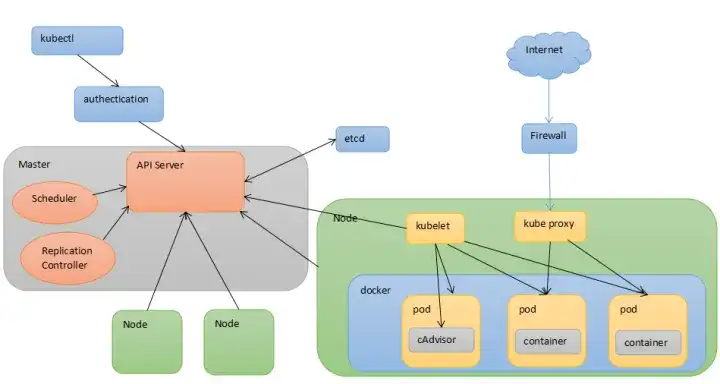

三、Kubernetes的术语

3.1 Master

Kubernetes的集群控制节点,负责整个集群的管理和控制,拥有一个etcd服务,用来保存所有资源对象的数据,我们执行的所有控制命令会发给他,他负责具体的执行过程,Master节点通常会独占一个服务器,在其上会运行以上一组关键的进程:

- Kubernetes API Server:提供Http Rest接口的关键服务进程,是Kubernetes中增、删、改、查等操作的唯一入口,是集群控制的入口进程。

- Kubernetes Controller Manager:Kubernetes中所有资源对象的自动化控制中心。

- Kubernetes Scheduler:负责资源调度的进程。

3.2 Node

Kubernetes集群中的其他机器被称为Node节点,Node节点可以是一台物理主机,也可以是一台虚拟机,每个Node节点会被Master节点分配一些负载,所以Node节点是Kubernetes集群中工作负载节点,当某个Node节点宕机时,工作负载会被Master自动转移到其他节点。Node节点之上会运行一组关键进程:

- kubelet:负责Pod对应容器的创建,启动、停止等任务。

- kube-proxy:实现Kubernetes Service通讯与负载均衡机制的重要组件。

- Docker Engine:Docker引擎,负责容器的创建和管理

3.3 Pod

Pod是Kurbernetes进行创建、调度和管理的最小单位,Pod运行在Node节点之上,其中包含多个业务容器,这些业务容器之间共享网络命名空间、Ip地址、端口,可以通过localhost进行通讯。Pod有两种类型:普通Pod和静态Pod。

3.4 Replication Controller

Kurbernetes用来管理和保证集群中拥有的Pod。

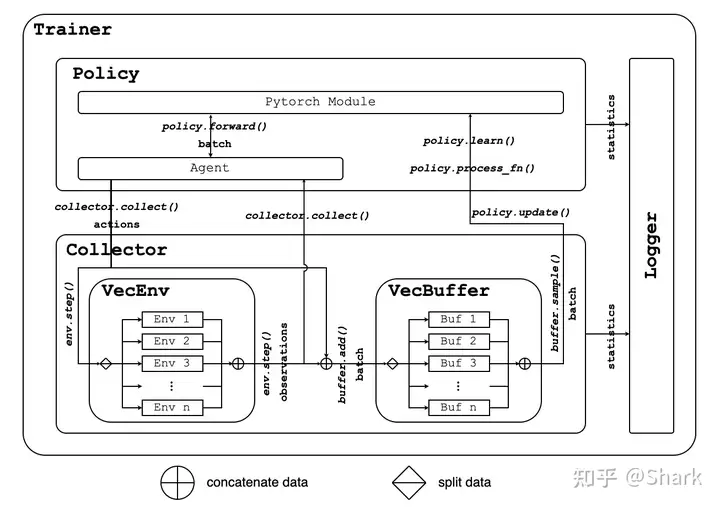

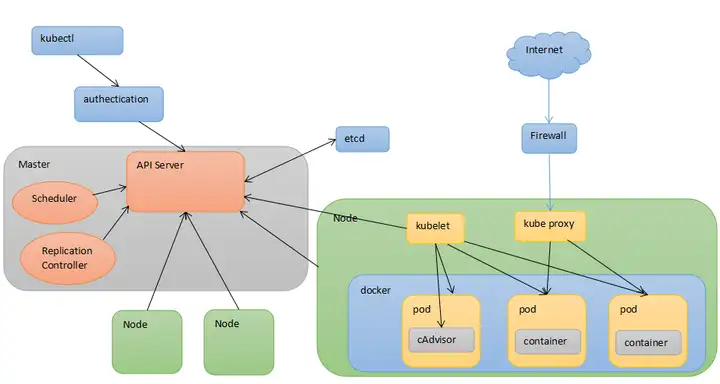

四、 Kubernetes的架构

Kubernetes的一切都是基于分布式的,下面这张图就是Kubernetes的架构图

通过这张架构图我们发现Kurbernetes主要由以下几个核心组件组成:

- Etcd:保存整个集群的状态。

- API Server:提供认证、授权、访问控制、API注册和发现等机制,是资源操作的唯一入口。

- Kurbernetes Controller:负责维护集群的状态。

- Scheduler:负责资源的调度。

- **kubelet**:负责维护容器的生命周期,同时管理Volume和网络。

- Container:负责镜像管理以及Pod和容器的真正运行。

- kube-proxy:负责为Service提供cluster内部的服务发现和负载均衡。

docker安装部署手册

十分钟学会用docker部署微服务 - 知乎 (zhihu.com)

史上最全Docker环境安装指南 - 知乎 (zhihu.com) (docker 安装)